DiffusionRenderer 是一种适用于神经逆向与正向渲染的通用方法。该方法可从输入图像或视频中,精准估计几何与材质缓冲区,并在指定光照条件下生成具备照片级真实感的图像,为图像编辑应用提供了基础工具。

摘要

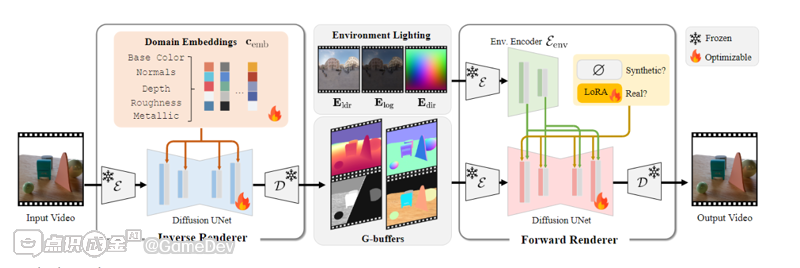

理解并建模光照效果是计算机视觉与图形学领域的基础性任务。传统的基于物理的渲染(PBR)虽能精确模拟光传输过程,但依赖于精确的场景表示 —— 包括显式三维几何、高质量材质属性及光照条件 —— 而这些在真实场景中往往难以获取。为此,我们提出了 DiffusionRenderer,这是一种基于神经机制的方法,能够在一个整体框架内解决逆向与正向渲染的双重问题。该方法借助强大的视频扩散模型先验,其逆向渲染模块可从真实世界视频中准确估计 G 缓冲区(注:图形学中常用的几何缓冲区,包含深度、法向量、材质 ID 等关键场景信息),既可为图像编辑任务提供交互接口,也能为渲染模块提供训练数据;反之,其渲染模块无需显式模拟光传输,即可从 G 缓冲区生成照片级真实感图像。实验结果表明,DiffusionRenderer 能有效实现逆向与正向渲染的近似计算,且性能持续优于当前最先进的方法。仅通过单段视频输入,该模型即可支持重光照、材质编辑、真实感物体插入等实际应用场景。

如上图,给定一段输入视频,神经逆向渲染器会逐像素估计几何与材质属性。该渲染器每次生成一种场景属性,其中领域嵌入(domain embedding) 用于指示待生成的目标属性。反之,给定光照信息、几何及材质缓冲区,神经正向渲染器可生成具备照片级真实感的图像。光照条件通过交叉注意力层(cross-attention layers) 注入基础视频扩散模型。在使用合成数据与真实数据进行联合训练的过程中,我们针对真实数据源采用了可优化的LoRA(低秩适应,Low-Rank Adaptation) 。

关键技术术语补充说明

- 领域嵌入(Domain Embedding):一种用于区分不同任务 / 属性类型的特征编码方式,此处通过该机制让模型明确当前需生成的 “几何”“材质” 等具体场景属性,确保生成目标的准确性。

- 交叉注意力层(Cross-Attention Layers):深度学习中用于建立不同模态数据(此处为 “光照条件” 与 “基础视频特征”)关联的模块,可将光照信息精准融入视频扩散模型的生成过程,保证光照与图像内容的一致性。

- Lo(低秩适应,Low-Rank Adaptation):一种轻量级模型微调技术,通过冻结基础模型参数、仅训练低秩矩阵来适配特定数据(此处为真实数据),既能提升模型在真实场景的性能,又能避免全量微调带来的计算开销。

研发动因

DiffusionRenderer 的设计初衷是联合考虑逆向与正向渲染问题,以此克服传统基于物理渲染(PBR)方法的局限性。

传统 PBR(基于物理的渲染)依赖网格等显式 3D 几何结构。若缺乏此类结构,屏幕空间光线追踪(SSRT)难以精准呈现阴影与反射效果。我们的正向渲染器无需显式路径追踪与 3D 几何结构,即可合成具有照片级真实感的光照效果。

PBR(基于物理的渲染)对 G 缓冲区(G-buffers)中的误差也十分敏感。即使用当前最先进的逆渲染模型估算出 G 缓冲区,采用该缓冲区的屏幕空间光线追踪(SSRT)仍常难以生成高质量结果。而我们的正向渲染器经训练后,能够容忍含噪缓冲区(noisy buffers)的存在。

(补充说明:G 缓冲区是图形渲染中存储场景几何、材质、光照等中间信息的集合,其精度直接影响后续渲染效果;“含噪缓冲区” 指因模型估算误差、数据采集干扰等导致信息存在偏差或杂讯的 G 缓冲区,这类缓冲区通常会严重影响传统渲染算法的输出质量。)

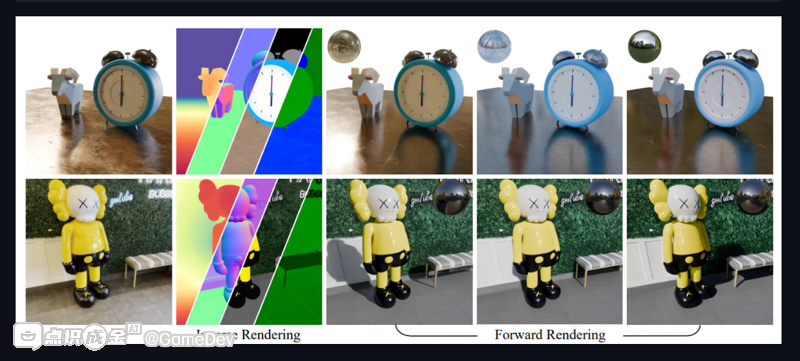

Forward Rendering

基于 G 缓冲区的视频生成:该正向渲染器能生成视角间保持一致性的精准阴影与反射效果。值得注意的是,尽管输入的 G 缓冲区不含显式阴影或反射信息,这些光照效果仍完全由环境贴图合成而来。

(补充说明:“视角间保持一致性” 指在视频不同帧的视角变化中,阴影、反射的位置和形态符合物理逻辑,无明显断层或错乱;环境贴图是一种记录场景周围光照信息的图像,可模拟全局光照效果,常用于渲染中还原真实环境光对物体的影响。)

正向渲染的定性对比结果显示:我们的方法能生成高质量的间接反射与阴影,相比神经基线方法(neural baselines),产出的结果精度更高。

Inverse Rendering

逆渲染器为 “去光照(de-lighting)” 提供了通用解决方案,能够生成法向量、反照率、粗糙度、金属度等精准且时间上一致的场景属性。

(补充说明:“去光照(de-lighting)” 是从含光照信息的图像中分离出物体本身属性(如颜色、材质)与光照信息的技术,是逆渲染的核心任务之一;“时间上一致” 指在视频序列中,生成的场景属性随时间变化连贯、无跳变,确保动态场景渲染的稳定性;反照率(albedo)特指物体表面反射光线的固有能力,不包含光照和阴影影响,是 PBR 等渲染技术中关键的材质参数。)

Relighting

我们在重新光照 Relighting任务中验证了逆渲染与正向渲染组合模型的有效性:利用逆渲染器估算出的 G 缓冲区,可对场景进行不同光照条件下的重新光照处理。

(补充说明:“重新光照(relighting)” 指在保持场景几何与材质不变的前提下,为场景替换或调整光照环境(如从晴天改为阴天、从侧光改为顶光)的技术,广泛用于影视后期、游戏场景编辑等领域;此处 “组合模型” 的核心逻辑是,先通过逆渲染拆解场景基础属性(G 缓冲区),再依托正向渲染实现光照的灵活替换,形成 “拆解 - 重构” 的完整工作流。)

应用

材质编辑

插入新物件

参考资料

NVIDIA最新发布

2025 年 6 月 12 日, 开源发布 Cosmos 扩散渲染器,这一重大升级由 NVIDIA Cosmos 平台支持并通过增强的数据管理技术显著提升了渲染质量。欢迎前往 GitHub 仓库体验! GitHub 仓库

2025 年 6 月 11 日,发布 Cosmos 扩散渲染器 的 视频演示 和技术博客,深入解析其核心技术与应用场景。技术博客

2025 年 6 月 11 日, 开放 DiffusionRenderer 学术版本 的代码与模型权重。该版本完整复现了论文中的实验结果,欢迎开发者探索 GitHub 仓库与模型资源。 学术版本代码 | 模型权重下载

关键术语说明

- Cosmos 扩散渲染器(Cosmos DiffusionRenderer)

基于 NVIDIA Cosmos 物理 AI 开发平台构建的新一代渲染系统,整合视频扩散模型与神经逆向 / 正向渲染技术,可从单目视频中高精度反推场景几何与材质信息(如 G 缓冲区),并生成符合物理规律的光照效果。 - NVIDIA Cosmos 平台(NVIDIA Cosmos)

专为自动驾驶与机器人领域设计的基础模型平台,集成生成式世界模型(WFM)、高速数据处理管道与多模态推理引擎,支持从文本 / 视频输入生成物理一致的动态场景。 - 增强的数据管理(Enhanced Data Curation)

通过自动化标注、噪声过滤与跨模态数据对齐技术,优化训练数据的多样性与准确性,确保模型在复杂场景下的泛化能力。